2023 个人研究 导师:Valentina Soanna

SEE THE SOUND—跨模态相互作用研究

城市声音特征的机器学习分类及其视觉动态表达

“看见”声音的不同

增强对不同声音的“感知”

和不同的声音产生不同的“互动方式”

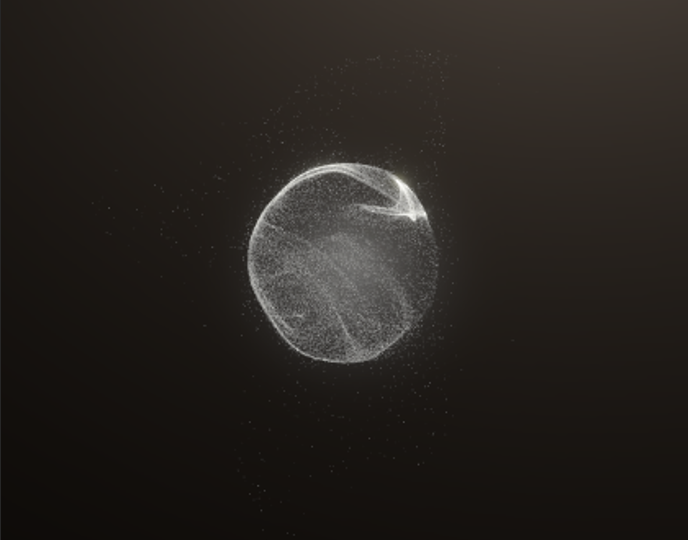

我们假设,不同种类城市声音中的特征是可以差异化的转化为视觉信号的,并且这些视觉信号可以为人们感知城市声音提供反馈。为此,我们使用包含8732个样本的10种城市声音作为数据集。利用深度学习和卷积神经网络(CNN),基于城市声音的Mel频率倒谱系数(MFCC)特征,我们成功地训练了一个声音识别模型。经过训练,模型能够有效地分类不同的城市声音。进一步地,我们在Unity中创建了一个映射系统,根据声音的种类和特征控制粒子的动态视觉效果,如颜色、运动速度和大小。

Python、C#、Librosa、PyTorch、TorchAudio、Unity、VFX、Barracuda、CNN、Machine-learning

MFCC转换处理,这是音频数据处理中非常重要的一步。MFCC是音频处理中的关键特征之一,因为它能够有效模拟人类听觉系统的频率感知,这使得基于MFCC的声音特征更接近人类的声音认知。我们需要提取出城市声音中的MFCC特征数据进行接下来的模型训练和研究。MFCC的获取步骤可简单概括为:将音频信号进行傅里叶变换算法计算后,将音频信号从时域转换到频域,接着通过Mel滤波组模拟人耳的频率感知,最后进行对数操作和离散余弦变换得到倒谱系数(Davis, S. B & Mermelstein, P., 1980)。

训练卷积神经网络涉及多个决策,包括架构(输入数据的格式、层的数量和大小、空间池的数量等)和学习超参数(学习率、批处理大小、dropout率等)。在决策过程中我们参考了不同声音深度学习的案例和文献,并根据训练验证结果进行了不断地调试。这种调试虽然不可能对所有地参数组和进行尝试和详尽地评估,但是这些调试也都选择最有希望地模型进行重要参数地调整(卷积层数、过滤器形状、学习率、dropout率等)